在AI迅猛发展的当下,图像生成领域的创新从未止步。从早期的GAN到近几年的扩散模型,如Stable Diffusion,图像生成技术已经在多种场景中展现了巨大的潜力。而最近一篇题为《OmniGen:统一的图像生成》的论文中,研究者们提出了一种革新性的通用模型,不仅填补了现有技术的空白,还简化了复杂的工作流程。

OmniGen是什么?

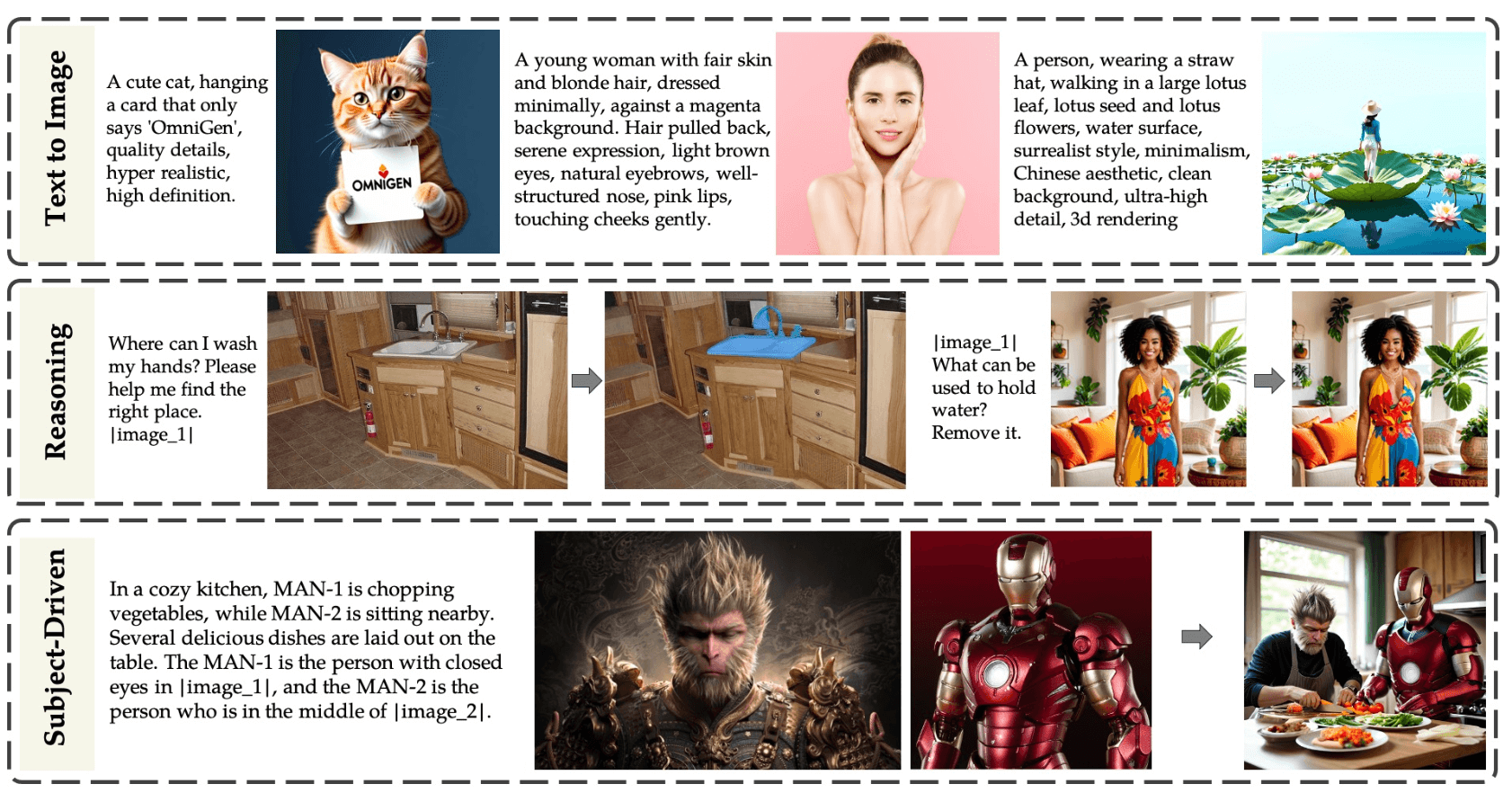

OmniGen是一种全新的扩散模型,它最大的特点在于“统一”。与Stable Diffusion等流行模型不同,OmniGen无需额外的模块(如ControlNet或IP-Adapter),便能处理多种控制条件。其设计目标是解决多个图像生成相关任务,譬如文本到图像的生成、图像编辑、基于特定对象的生成以及视觉条件生成等。其架构经过高度简化,用户无需进行繁琐的预处理步骤,这大大降低了使用门槛。

知识迁移与多任务支持

OmniGen最核心的创新点在于其卓越的知识迁移能力。通过将不同任务统一在一个框架中训练,该模型能够在不同任务间有效转移知识,不仅可以处理现有的任务,还展现了应对新任务和领域的潜力。OmniGen的这种“链式思维”能力,进一步拓展了AI模型的推理和泛化能力。

OmniGen的多任务处理能力,使其在图像生成之外,还能胜任许多经典的计算机视觉任务。无论是边缘检测、人体姿态识别等问题,OmniGen都能通过图像生成任务的转换机制来解决。

通用型生成模型的机遇

OmniGen的推出意味着一个全新的市场机会。传统的图像生成模型往往需要多个子模块配合完成不同任务,而OmniGen的统一框架不仅减少了开发成本,还提升了开发效率。对图像生成需求广泛的领域,如广告创作、游戏设计、虚拟世界构建等,OmniGen都有着巨大的应用潜力。

此外,随着生成式AI在各行业的普及,能以更简洁的方式处理多种任务的通用型模型将成为主流趋势。OmniGen无疑抓住了这一风口,定位为未来图像生成的核心解决方案。

背后的团队与技术支持

OmniGen的研究团队由来自多个领域的顶尖专家组成,他们在计算机视觉、深度学习及自然语言处理等领域拥有丰富的经验。团队中的核心成员Shitao Xiao、Yueze Wang等人在AI领域发表过多篇重量级论文,推动了生成模型的发展。

该项目的技术支持背后,有着强大的开源社区力量。OmniGen的相关资源将逐步在GitHub上开放,进一步促进学术界和工业界的合作。这种开放性为OmniGen的持续优化提供了良好的基础。

使用指南与社区支持

OmniGen的使用相对简便。由于其消除了传统生成模型中繁琐的预处理步骤,用户仅需简单的指令便可完成复杂的生成任务。例如,对于人体姿态识别任务,用户无需进行单独的姿态估计,OmniGen便能在生成图像的过程中自动处理这些细节。

目前,该模型的开源代码和示例已经开始在GitHub上积累人气,社区的Star数量持续攀升。此外,研究团队计划将其部署到Hugging Face的空间中,进一步简化模型的使用门槛,让更多开发者能够轻松体验到OmniGen的强大能力。

OmniGen与现有模型

在现有的图像生成领域,Stable Diffusion、DALL·E等模型无疑占据了很大市场份额。但这些模型在处理复杂控制条件时,往往依赖外部模块或预处理。而OmniGen凭借其内置的多任务处理能力和简化的架构,无需额外模块便能直接应对各种生成需求。相比之下,OmniGen大大降低了使用门槛,同时增强了模型的扩展性。

然而,作为一个相对较新的模型,OmniGen依然面临一些未解决的问题。比如,如何进一步提升模型的推理速度,如何在更广泛的场景下验证其通用性,这些都是未来优化的方向。

数智朋克点评

OmniGen作为一款通用型的图像生成模型,为AI图像生成领域带来了简化和统一的新思路。其高效的知识迁移和多任务处理能力,使其具备了极大的市场潜力。

粤公网安备44030002001270号

粤公网安备44030002001270号